Informática: La discriminación injusta usando tecnología ni es inteligente ni es artificial

La discriminación injusta usando tecnología ni es inteligente ni es artificial

El 'software' de inteligencia artificial aplicado a reconocimiento facial y otras actividades en el ámbito de la salud o la justicia tiene fallos graves. ¿Qué hacer para evitarlos?

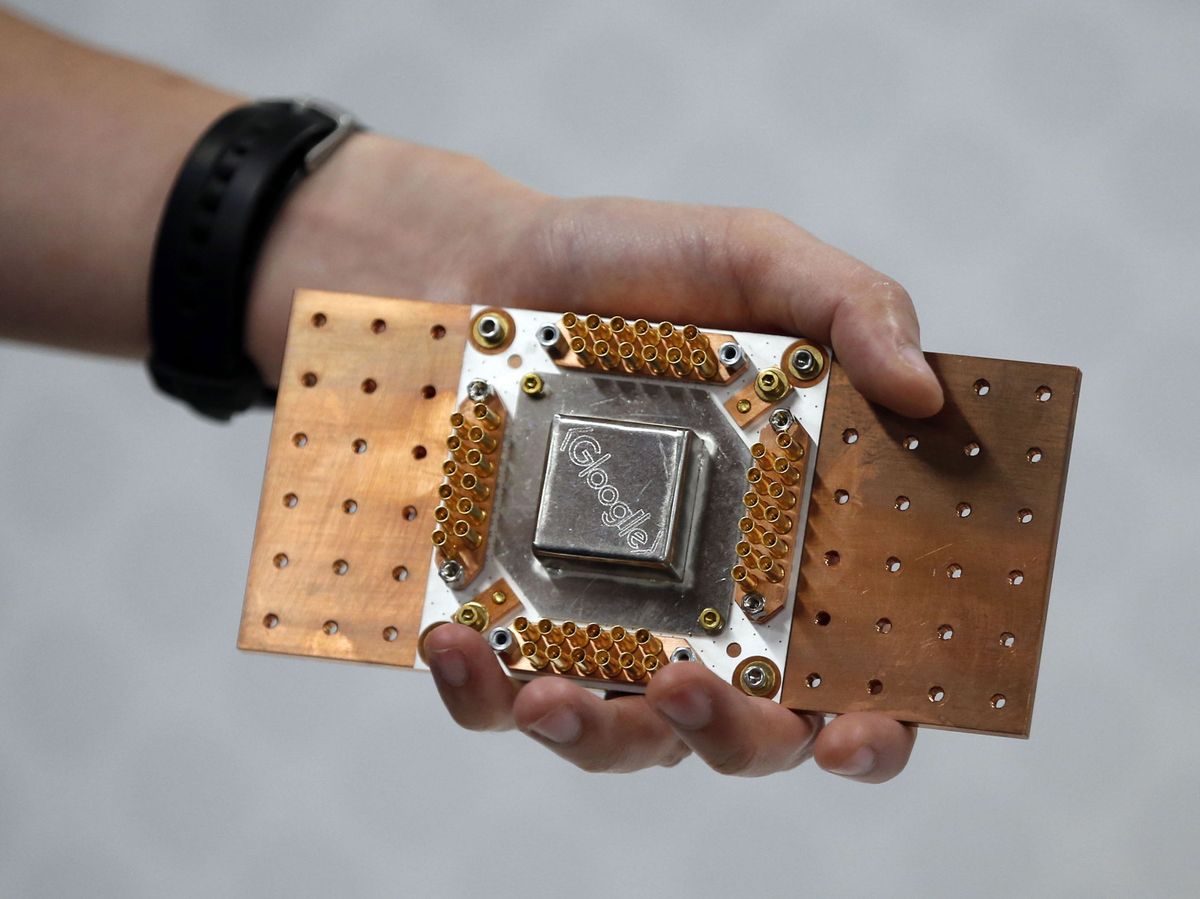

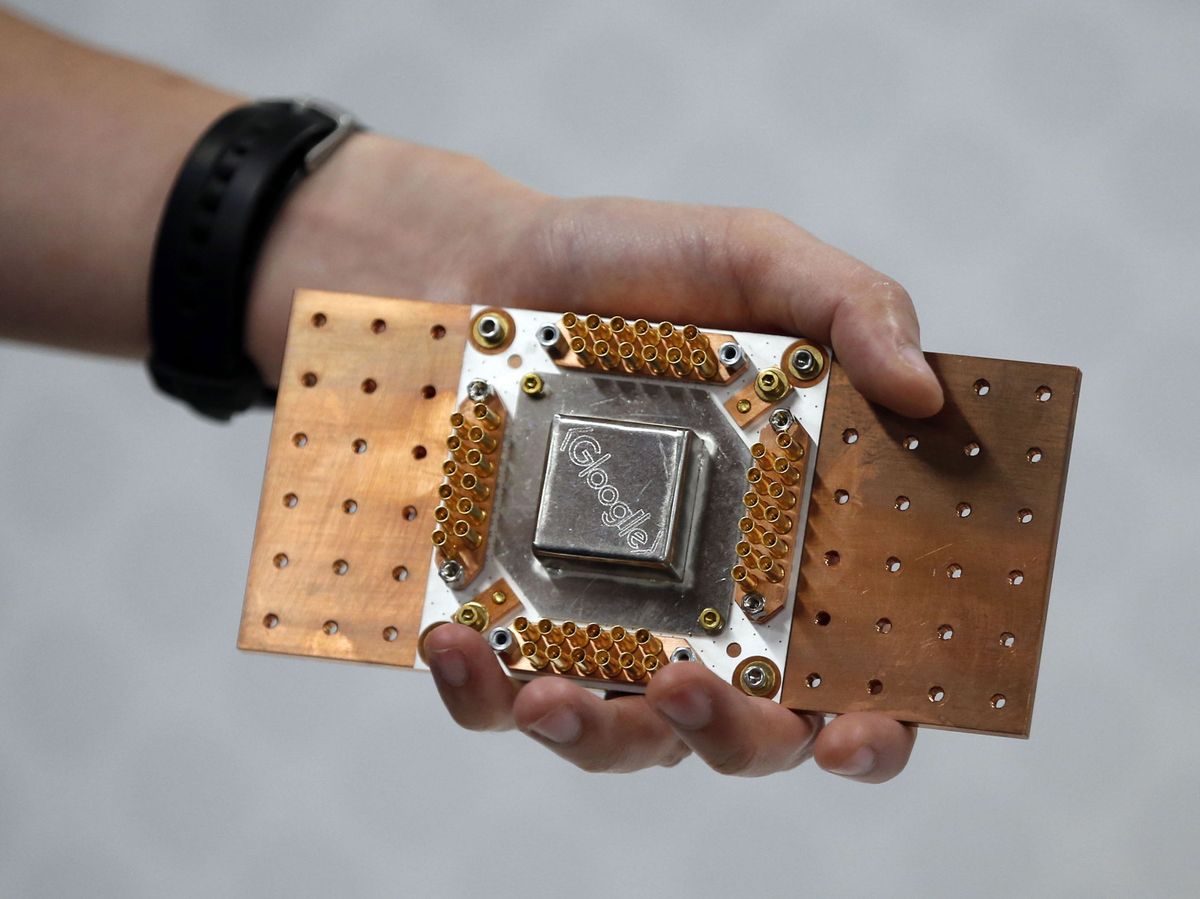

Procesador cuántico diseñado por Google y mostrado en 2020 en un evento de la compañía sobre inteligencia artificial. (Reuters)

Procesador cuántico diseñado por Google y mostrado en 2020 en un evento de la compañía sobre inteligencia artificial. (Reuters)

Por

Adolfo Corujo

19/03/2021 - 05:00

Pasas por un control de seguridad de un aeropuerto o de un edificio oficial y, de repente, los agentes te piden que salgas de la fila y les acompañes. Es algo a lo que todos estamos expuestos, pero no de la misma manera. Si eres mujer y el punto de vigilancia usa un sistema “inteligente” de reconocimiento facial, tienes más opciones de ser retenida. Ocurre lo mismo si eres una persona de color. Los servicios basados en 'machine learning' resultan más eficaces con varones blancos. Han sido entrenados con bancos de imágenes en los que abundan este estereotipo y aplican mejor los métodos de análisis visual. Por tanto, en el caso de mujeres y de personas de raza afroamericana se producen más errores y, ya sea porque generan más falsos positivos y negativos o porque simplemente no les identifican, eso multiplica las posibilidades de que sufran una discriminación evidente.

Este hecho se puso por primera vez de manifiesto en 2019, cuando el MIT y la Universidad de Toronto presentaron los resultados de un análisis que identificaba debilidades con graves repercusiones en este tipo de herramientas. Luego, 85 organizaciones exigieron a las grandes tecnológicas que detuvieran el desarrollo de sus proyectos y el suministro a sus clientes de sus servicios de reconocimiento. La campaña logró calar en la comunidad empresarial: a mediados de 2020, IBM anunció que discontinuaba esta línea de negocio. Le siguieron Microsoft y Amazon que comunicaron que dejarían de suministrar sus productos a las fuerzas de seguridad de los estados.

Opinión

Opinión

Un taxi con una 'app' sigue siendo un taxi: la gran falacia de las tecnológicas

Eduardo Manchón

Aún así, el tema no ha dejado de generar polémica. La última ha sido protagonizada por Google. El gigante ha despedido en menos de dos meses a las dos líderes de su equipo de ética e inteligencia artificial, Timnit Gebru y Margaret Mitchell. Ambas participaron activamente en la difusión de los estudios que denunciaban las consecuencias de los sesgos en los entrenamientos de las máquinas no solo en el caso de las imágenes sino también en otros campos como el de la generación automática de textos. La empresa desmiente que su decisión esté relacionada con esa actitud crítica de las dos investigadoras; aunque fuera así, las opiniones de ambas se encuentran entre las de mayor credibilidad a la hora de identificar los peligros de un uso indiscriminado de estas tecnologías.

(Reuters)

(Reuters)

El asunto es sencillo. El funcionamiento de cualquier sistema de inteligencia artificial depende de la calidad de los datos con los que se ha entrenado. Si los datos o la forma en la que se han procesado o tratado contienen cualquier sesgo, el resultado vendrá condicionado por ese prejuicio. Y eso puede tener graves consecuencias.

Diferentes organizaciones y empresas llevan años empleando estas técnicas para multitud de propósitos. Un ejemplo es el de la herramienta COMPAS (Correctional Offender Management Profiling for Alternative Sanctions) que se utiliza en ciertos condados de los Estados Unidos. El objetivo del programa era y es ayudar a los jueces a valorar el potencial de reincidencia de un acusado. Sobre el papel, el análisis de comportamientos almacenados en los archivos de los juzgados y de las penitenciarías parece un excelente punto de partida para contribuir en esa valoración. Sin embargo, desde 2016 se han multiplicado, por un lado, las denuncias por la desproporción con la que prejuzga a los individuos en función de su raza y, por otro, las advertencias del propio suministrador del servicio dirigidas a los jueces para explicarles que se trata de una valoración preliminar sobre la que no debería fundar sus sentencias.

Disfrutamos y sufrimos a diario con otro ejemplo. Las redes sociales cuentan con sistemas de inteligencia artificial dirigidos a orientar el contenido que nos llega. Si detectan que un patrón de éxito es la carga polémica de una noticia, difundirán ese tipo de informaciones y contribuirán a generar un estado de opinión cainita. Y ya sabemos, por experiencia, lo que eso provoca.

Sundar Pichai, CEO de Google. (Reuters)

Sundar Pichai, CEO de Google. (Reuters)

Pero lo mismo sucede con la adopción por parte de las empresas de máquinas para ayudarles en la búsqueda y selección de candidatos para un puesto de trabajo. Entrenadas a partir de grandes volúmenes de datos, sin controlar los sesgos, producen resultados equívocos y muchas veces escandalosos. Se suele mencionar la situación que vivió Amazon en Estados Unidos. Su departamento de recursos humanos usaba un sistema que clasificaba de forma automática los perfiles de mujeres sugiriéndolos de manera sesgada hacia ciertas posiciones administrativas. Pero desde luego no fue el primero, tampoco el único y, por desgracia, no será el último.

Ahora bien, no es inevitable. Cualquier organización que quiera beneficiarse de las ventajas evidentes de aplicar la inteligencia artificial a su gestión debe y puede controlar los sesgos. Si se produce una discriminación injusta, la responsabilidad recae sobre el que está utilizando la máquina y no sobre la propia máquina. Exige una mirada más amplia sobre su uso que la simple valoración del software, algo que, por cierto, demanda la mayor parte de las cosas que hace cualquier empresa o gobierno. Conlleva un proceso de prueba más concienzudo, desplegar sus capacidades de una forma paulatina y transparentar a las personas y a las autoridades que se está utilizando, el porqué y el para qué. Y, por supuesto, implica que sus líderes estén atentos y preparados para reparar el daño que puedan provocar.

En cuanto a los ciudadanos, debemos ser conscientes de que estas nuevas capacidades nos benefician siempre que se apliquen dentro de ese marco honesto de operación. Los prejuicios han existido desde que vivimos en sociedad. Hoy precisamente esta tecnología inteligente nos permite reducir su impacto. Exijamos que eso ocurra a marcas, empleadores y gobiernos. Pero no caigamos en el error de pensar que se trata de un defecto de los avances. La discriminación inapropiada nunca ha sido inteligente, tampoco artificial.

*Adolfo Corujo es Socio y Director Global de Estrategia e Innovación en LLYC.

La discriminación injusta usando tecnología ni es inteligente ni es artificial

El 'software' de inteligencia artificial aplicado a reconocimiento facial y otras actividades en el ámbito de la salud o la justicia tiene fallos graves. ¿Qué hacer para evitarlos?

Procesador cuántico diseñado por Google y mostrado en 2020 en un evento de la compañía sobre inteligencia artificial. (Reuters)

Procesador cuántico diseñado por Google y mostrado en 2020 en un evento de la compañía sobre inteligencia artificial. (Reuters)Por

Adolfo Corujo

19/03/2021 - 05:00

Pasas por un control de seguridad de un aeropuerto o de un edificio oficial y, de repente, los agentes te piden que salgas de la fila y les acompañes. Es algo a lo que todos estamos expuestos, pero no de la misma manera. Si eres mujer y el punto de vigilancia usa un sistema “inteligente” de reconocimiento facial, tienes más opciones de ser retenida. Ocurre lo mismo si eres una persona de color. Los servicios basados en 'machine learning' resultan más eficaces con varones blancos. Han sido entrenados con bancos de imágenes en los que abundan este estereotipo y aplican mejor los métodos de análisis visual. Por tanto, en el caso de mujeres y de personas de raza afroamericana se producen más errores y, ya sea porque generan más falsos positivos y negativos o porque simplemente no les identifican, eso multiplica las posibilidades de que sufran una discriminación evidente.

Este hecho se puso por primera vez de manifiesto en 2019, cuando el MIT y la Universidad de Toronto presentaron los resultados de un análisis que identificaba debilidades con graves repercusiones en este tipo de herramientas. Luego, 85 organizaciones exigieron a las grandes tecnológicas que detuvieran el desarrollo de sus proyectos y el suministro a sus clientes de sus servicios de reconocimiento. La campaña logró calar en la comunidad empresarial: a mediados de 2020, IBM anunció que discontinuaba esta línea de negocio. Le siguieron Microsoft y Amazon que comunicaron que dejarían de suministrar sus productos a las fuerzas de seguridad de los estados.

Opinión

OpiniónUn taxi con una 'app' sigue siendo un taxi: la gran falacia de las tecnológicas

Eduardo Manchón

Aún así, el tema no ha dejado de generar polémica. La última ha sido protagonizada por Google. El gigante ha despedido en menos de dos meses a las dos líderes de su equipo de ética e inteligencia artificial, Timnit Gebru y Margaret Mitchell. Ambas participaron activamente en la difusión de los estudios que denunciaban las consecuencias de los sesgos en los entrenamientos de las máquinas no solo en el caso de las imágenes sino también en otros campos como el de la generación automática de textos. La empresa desmiente que su decisión esté relacionada con esa actitud crítica de las dos investigadoras; aunque fuera así, las opiniones de ambas se encuentran entre las de mayor credibilidad a la hora de identificar los peligros de un uso indiscriminado de estas tecnologías.

(Reuters)

(Reuters)El asunto es sencillo. El funcionamiento de cualquier sistema de inteligencia artificial depende de la calidad de los datos con los que se ha entrenado. Si los datos o la forma en la que se han procesado o tratado contienen cualquier sesgo, el resultado vendrá condicionado por ese prejuicio. Y eso puede tener graves consecuencias.

Diferentes organizaciones y empresas llevan años empleando estas técnicas para multitud de propósitos. Un ejemplo es el de la herramienta COMPAS (Correctional Offender Management Profiling for Alternative Sanctions) que se utiliza en ciertos condados de los Estados Unidos. El objetivo del programa era y es ayudar a los jueces a valorar el potencial de reincidencia de un acusado. Sobre el papel, el análisis de comportamientos almacenados en los archivos de los juzgados y de las penitenciarías parece un excelente punto de partida para contribuir en esa valoración. Sin embargo, desde 2016 se han multiplicado, por un lado, las denuncias por la desproporción con la que prejuzga a los individuos en función de su raza y, por otro, las advertencias del propio suministrador del servicio dirigidas a los jueces para explicarles que se trata de una valoración preliminar sobre la que no debería fundar sus sentencias.

Disfrutamos y sufrimos a diario con otro ejemplo. Las redes sociales cuentan con sistemas de inteligencia artificial dirigidos a orientar el contenido que nos llega. Si detectan que un patrón de éxito es la carga polémica de una noticia, difundirán ese tipo de informaciones y contribuirán a generar un estado de opinión cainita. Y ya sabemos, por experiencia, lo que eso provoca.

Sundar Pichai, CEO de Google. (Reuters)

Sundar Pichai, CEO de Google. (Reuters)Pero lo mismo sucede con la adopción por parte de las empresas de máquinas para ayudarles en la búsqueda y selección de candidatos para un puesto de trabajo. Entrenadas a partir de grandes volúmenes de datos, sin controlar los sesgos, producen resultados equívocos y muchas veces escandalosos. Se suele mencionar la situación que vivió Amazon en Estados Unidos. Su departamento de recursos humanos usaba un sistema que clasificaba de forma automática los perfiles de mujeres sugiriéndolos de manera sesgada hacia ciertas posiciones administrativas. Pero desde luego no fue el primero, tampoco el único y, por desgracia, no será el último.

Ahora bien, no es inevitable. Cualquier organización que quiera beneficiarse de las ventajas evidentes de aplicar la inteligencia artificial a su gestión debe y puede controlar los sesgos. Si se produce una discriminación injusta, la responsabilidad recae sobre el que está utilizando la máquina y no sobre la propia máquina. Exige una mirada más amplia sobre su uso que la simple valoración del software, algo que, por cierto, demanda la mayor parte de las cosas que hace cualquier empresa o gobierno. Conlleva un proceso de prueba más concienzudo, desplegar sus capacidades de una forma paulatina y transparentar a las personas y a las autoridades que se está utilizando, el porqué y el para qué. Y, por supuesto, implica que sus líderes estén atentos y preparados para reparar el daño que puedan provocar.

En cuanto a los ciudadanos, debemos ser conscientes de que estas nuevas capacidades nos benefician siempre que se apliquen dentro de ese marco honesto de operación. Los prejuicios han existido desde que vivimos en sociedad. Hoy precisamente esta tecnología inteligente nos permite reducir su impacto. Exijamos que eso ocurra a marcas, empleadores y gobiernos. Pero no caigamos en el error de pensar que se trata de un defecto de los avances. La discriminación inapropiada nunca ha sido inteligente, tampoco artificial.

*Adolfo Corujo es Socio y Director Global de Estrategia e Innovación en LLYC.

Comentarios